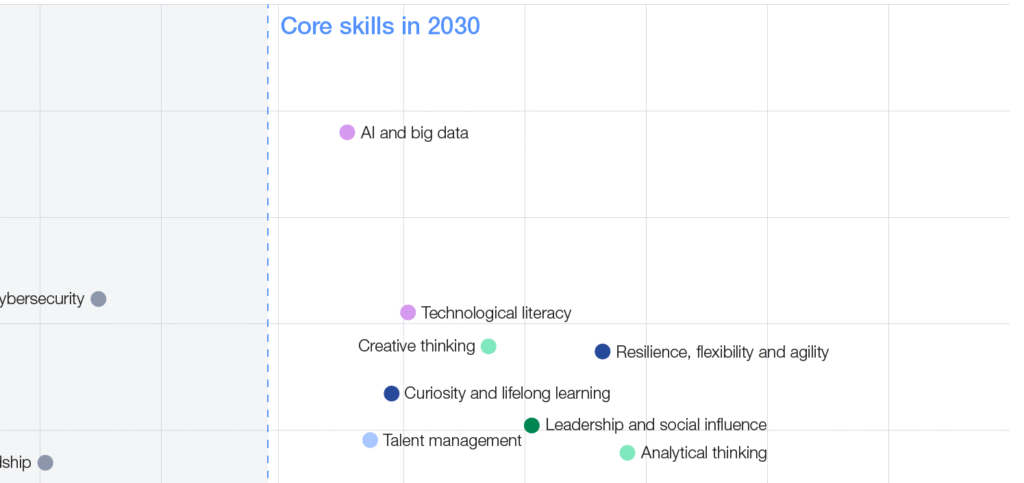

Las habilidades emergentes identificadas en el estudio que la World Economic Forum ha publicado y que analiza el Porcentaje de empleadores que consideran las habilidades como una competencia esencial en 2025 (%) contra Porcentaje de empleadores que prevén un aumento en el uso de habilidades para 2030 (%), me motivó a escribir este artículo para pensar en qué cambios debemos provocar en nosotros como testers ágiles en cuanto a nuestras habilidades profesionales, así como también qué actividades y/o tareas dentro de nuestros procesos de testing debemos identificar para ir provocando cambios con vistas a estar preparados en el 2030, ¡Todo un desafío este roadmap verdad!

La lista de habilidades emergentes

Dentro del estudios de la World Economic Forum hay una gráfica en la que uno de sus cuadrantes muestra las siguientes habilidades:

- AI and big data (IA y Big Data)

- Networks and cybersecurity (Redes y ciberseguridad)

- Talent management (Gestión del talento)

- Environmental stewardship (Custodia ambiental)

- Design and user experience (Diseño y experiencia de usuario)

- Programming (Programación)

- Marketing and media (Marketing y medios)

- Teaching and mentoring (Enseñanza y mentoría)

- Global citizenship (Ciudadanía global)

- Quality control (Control de calidad)

- Multi-lingualism (Multilingüismo)

- Sensory-processing abilities (Habilidades de procesamiento sensorial)

- Reading, writing and mathematics (Lectura, escritura y matemáticas)

- Manual dexterity, endurance and precision (Destreza manual, resistencia y precisión)

¿Qué cambios deberíamos provocar en nosotros?

Desarrollo personal del Líder de QA hacia el 2030

Debemos pensar en un diseñar nuestro propio camino de aprendizaje continuo. Aquí un ejemplo práctico de cómo podría hacerlo:

Meta 2030: Poder dialogar con especialistas en datos y seguridad, y liderar estrategias de prueba que aborden estos dominios de forma informada.

Dominio profundo de IA Generativa y Prompt Engineering (habilidad dura):

Acción: No solo leer, sino practicar intensivamente con LLMs (usando interfaces como las que se proponene en el Syllabus AiU GenAI-Assisted Test Engineer_v1.0. Dedicar tiempo semanal a experimentar con patrones de prompting avanzados (Few-Shot, CoT, Persona) aplicados a artefactos reales (requisitos, logs, casos de prueba existentes).

Capacitación: Realizar cursos especializados en Prompt Engineering (como el detallado en el Syllabus AiU GenAI-Assisted Test Engineer_v1.0) y seguir a referentes en IA aplicada al testing. Utilizar los LLMs para explicar conceptos complejos de IA (ej. «Explícame RAG como si fuera un Líder de QA»).

Meta 2030: Ser capaz de diseñar frameworks de prompts robustos y reutilizables para el equipo y auditar críticamente la salida de la IA.

Visión estratégica y gestión de riesgos ampliada (habilidad dura/blanda):

Acción: Aplicar los principios de pruebas basadas en riesgos (concepto y práctica contenida en el Syllabus ISTQB TM) no solo al producto, sino al propio proceso de adopción de IA. ¿Cuáles son los riesgos de usar GenAI en este proyecto? ¿Cómo mitigarlos?

Capacitación: Estudiar modelos de costo de la calidad (concepto y práctica contenida en el Syllabus ISTQB TM) y cómo la IA puede impactar (reducir costos de fallo interno/externo, y considerar ¿Aumentar costos de evaluación/prevención?). Utilizar LLMs para simular escenarios de riesgo y proponer estrategias de mitigación.

Meta 2030: Poder articular el valor y los riesgos de la IA en QA ante stakeholders de negocio, utilizando datos y proyecciones.

Liderazgo adaptativo y coaching (habilidad blanda):

Acción: Practicar activamente el coaching con miembros del equipo, ayudándoles a superar barreras en la adopción de nuevas prácticas (incluida la IA). Facilitar retrospectivas (concepto y práctica contenida en el Syllabus ISTQB TM) enfocadas en la mejora continua y la adaptación al cambio.

Capacitación: Tomar cursos de liderazgo situacional, comunicación y facilitación. Utilizar LLMs para preparar agendas de coaching o analizar dinámicas de equipo (con datos anonimizados).

Meta 2030: Liderar equipos diversos (incluyendo especialistas en IA) en entornos de alta incertidumbre, fomentando la seguridad psicológica y el aprendizaje.

Mentalidad holística y enfoque en el valor (habilidad blanda):

Acción: Aplicar el modelo de testing holístico en todas las iniciativas, no solo en testing. ¿Cómo impacta la IA en el descubrimiento, planificación, observabilidad? Pensar más allá de la ejecución de pruebas.

Capacitación: Involucrarse en comunidades de práctica de Producto y DevOps para entender el ciclo de vida completo. Usar LLMs para analizar el feedback de usuario y correlacionarlo con la estrategia de pruebas.

Meta 2030: Ser un champion de la calidad punta a punta, conectando las actividades de QA directamente con el valor entregado al cliente.

Alfabetización en datos y ciberseguridad (habilidad dura):

Acción: Aprender los fundamentos de análisis de datos para interpretar métricas de testing complejas y los resultados de herramientas de observabilidad. Familiarizarse con los riesgos de ciberseguridad asociados a la IA (prompt injection, data poisoning) (Syllabus AiU GenAI-Assisted Test Engineer_v1.0).

Capacitación: Cursos introductorios online sobre Data Science y Ciberseguridad. Utilizar LLMs para generar scripts básicos de análisis de datos o explicar vulnerabilidades comunes.

Explicación breve del tema central

¿Qué cambios deberíamos provocar en nuestros proyectos?

Implementación en un proyecto piloto: «Project ABC» (a modo de ejemplo)

Contexto del piloto: «Project ABC» es el desarrollo de una nueva funcionalidad para el portal de clientes existente (ej. un módulo de autogestión de perfil y preferencias). Es de complejidad moderada, involucra UI y APIs, y tiene stakeholders de negocio (Marketing) y técnicos (Desarrollo, Operaciones) claramente definidos.

Fases de implementación por el Líder de QA:

Impacto: Construye confianza y apoyo para una adopción más amplia (o justifica ajustes).

Fase 1: Preparación y habilitación (Kick-off – Sprint 0/1):

Función del Líder: Definir el alcance piloto y los objetivos SMART para la IA. Ej: «Utilizar GenAI en ABC para reducir el tiempo de revisión de requisitos en un 15% y generar el 30% de los casos de prueba de API (esqueleto inicial) para el Sprint 3, validando la calidad manualmente.» (Aquí, para este caso del Piloto, hasta podríamos implementar OKRs + KPIs)

Equipo: Seleccionar miembros del equipo (testers, 1 dev) con interés en IA. Organizar una sesión introductoria basada en Syllabus AiU GenAI-Assisted Test Engineer_v1.0 (Fundamentos, Beneficios, Riesgos).

Herramientas: Establecer acceso controlado a un LLM aprobado (ej. versión empresarial o un Playground seguro según Syllabus AiU GenAI-Assisted Test Engineer_v1.0).

Procesos: Adaptar ligeramente el Definition of Done (DoD) del piloto para incluir tareas opcionales asistidas por IA (ej. «Revisión de HU asistida por LLM»).

Fase 2: Integración ágil/holística con foco en IA (Sprints 1-3):

Revisión de requisitos:

Líder: Facilita sesiones donde el equipo usa Prompt Engineering (Syllabus AiU GenAI-Assisted Test Engineer_v1.0) para pedir al LLM que identifique ambigüedades, inconsistencias o falta de criterios de aceptación en las Historias de Usuario de ABC. Prompt ejemplo: «Actúa como un Analista de QA experto. Revisa la siguiente HU [pegar HU]. Identifica verbos ambiguos, criterios de aceptación faltantes y posibles inconsistencias con la HU [pegar HU relacionada]. Formatea como lista.»

Impacto: Acelera la detección temprana de defectos en requisitos. Capacita al equipo en prompts de análisis.

Diseño de pruebas:

Líder: Guía al equipo para usar el LLM como generador de ideas/esqueletos de casos de prueba para las APIs del módulo de perfil, aplicando técnicas sistemáticas (Syllabus AiU GenAI-Assisted Test Engineer_v1.0). Prompt ejemplo: «Genera casos de prueba Gherkin (Scenario Outline) para la API PUT /user/profile basada en estos criterios de aceptación [pegar criterios]. Incluye particiones de equivalencia y valores límite para el campo ‘edad’ (rango válido 18-99).»

Impacto: Reduce el tiempo de diseño inicial. Validación humana obligatoria por parte de los testers para refinar, completar y asegurar la relevancia.

Generación de datos de prueba:

Líder: Enseña al equipo a generar datos sintéticos para cubrir escenarios específicos (Syllabus AiU GenAI-Assisted Test Engineer_v1.0). Prompt ejemplo: «Genera 10 registros JSON válidos para la API POST /user/preferences, asegurando diversidad en el campo ‘newsletter_frequency’ (daily, weekly, monthly, never) y formato correcto en ‘preferred_contact_method’ (email, sms).» Restricción: No generar PII real.

Impacto: Acelera la creación de datos variados para pruebas funcionales y de contorno. Requiere revisión para evitar sesgos o datos irreales.

Fase 3: Gestión de defectos y reportes asistidos (continuo):

Bug Advocacy:

Líder: Muestra cómo usar LLMs para mejorar informes de defectos, haciéndolos más claros o sugiriendo posibles causas raíz basadas en logs (si se proporcionan de forma segura) (Syllabus AiU GenAI-Assisted Test Engineer_v1.0). Prompt ejemplo: «Reformula este informe de defecto [pegar borrador] para que sea más claro para un stakeholder no técnico. Enfócate en el impacto al usuario. Sugiere 2 posibles áreas generales del código donde podría estar el fallo basado en este log [pegar log anonimizado].»

Impacto: Mejora la comunicación con desarrollo y stakeholders. Acelera el triaje.

Informes de progreso:

Líder: Experimenta usando LLMs para resumir datos de ejecución (ej. de un CSV exportado) o redactar borradores de informes de estado del piloto.

Impacto: Potencial ahorro de tiempo en tareas administrativas. Verificación humana esencial de la precisión de los datos y conclusiones.

Fase 4: Feedback y mejora continua (cada Sprint y final del Piloto):

Retrospectivas:

Líder: Facilita retrospectivas específicas sobre el uso de GenAI. ¿Qué funcionó? ¿Qué no? ¿Qué prompts fueron efectivos? ¿Dónde hubo alucinaciones? ¿Cómo mejorar la colaboración humano-IA?

Impacto: Genera aprendizaje práctico y mejora la estrategia de Prompt Engineering del equipo.

Métricas:

Líder: Recopila las métricas definidas (reducción tiempo revisión, % casos generados, feedback cualitativo del equipo y stakeholders).

Impacto: Evalúa objetivamente el ROI y los desafíos del piloto. (En caso de que hayas implementado OKRs y KPIs deberás tener en cuenta también los datos que puedas producir a través de los mismos).

Stakeholders:

Líder: Presenta los resultados del piloto a stakeholders, destacando éxitos, aprendizajes y próximos pasos recomendados. Gestiona expectativas realistas.

Conclusiones

La integración de las habilidades emergentes identificadas para 2030, particularmente IA y Big Data, junto con los enfoques ágiles y holísticos, redefine profundamente tanto las (a) habilidades profesionales requeridas para el Liderazgo de QA como las (b) actividades y tareas dentro del proceso de testing.

(a) Evolución de habilidades profesionales del Líder de QA

El Líder de QA del futuro cercano debe trascender la gestión tradicional para convertirse en un integrador estratégico y un habilitador tecnológico. Esto implica:

- Competencia dual: Mantener la solidez en fundamentos de gestión de pruebas (estrategia, riesgo, métricas, equipo) y, simultáneamente, dominar los principios ágiles y holísticos (Whole Team, mejora continua, foco en valor).

- Expertise en IA Generativa: Adquirir fluidez práctica en Prompt Engineering avanzado, comprender arquitecturas como RAG, y evaluar críticamente las capacidades y limitaciones de los LLMs aplicados al testing.

- Habilidades blandas potenciadas: Reforzar el coaching, la facilitación, la comunicación y el pensamiento estratégico para guiar al equipo en la adopción de nuevas tecnologías, gestionar el cambio y articular el valor de QA (incluyendo el ROI de la IA) ante stakeholders.

- Alfabetización ampliada: Desarrollar conocimientos básicos en análisis de datos (para métricas y observabilidad) y ciberseguridad (para entender los riesgos asociados a la IA).

(b) Transformación de actividades y tareas en el proceso de Testing

La implementación (como en el piloto «Project ABC») introduce cambios significativos:

- Asistencia inteligente: Tareas como la revisión de requisitos, generación de ideas y esqueletos de casos de prueba, generación de datos sintéticos, y mejora de informes de defectos se ven aceleradas y potenciadas por LLMs.

- Validación humana crítica: Se refuerza la necesidad del juicio experto humano. Los artefactos generados por IA requieren revisión, refinamiento y validación para asegurar relevancia, precisión y ausencia de sesgos o alucinaciones. El rol humano se desplaza hacia la curación y la estrategia.

- Nuevas tareas: Surge la necesidad de diseñar, probar y mantener prompts efectivos, configurar y evaluar herramientas de IA, y potencialmente testear la propia IA (auditoría de sesgos, pruebas adversarias).

- Integración en flujos existentes: Las actividades asistidas por IA no reemplazan, sino que se integran en los flujos Ágiles/Holísticos existentes (ej. IA en retrospectivas, IA en sesiones de BDD/ATDD).

Riesgos y Resistencias (Perspectiva del Sponsor)

El sponsor del proyecto piloto debe ser consciente de los siguientes desafíos:

- Riesgos Clave:

- Curva de aprendizaje e inversión inicial: El equipo necesitará tiempo y presupuesto para capacitación en Prompt Engineering y herramientas de IA. El ROI puede no ser inmediato.

- Calidad de la salida de IA: Las alucinaciones y sesgos son un riesgo real que requiere procesos de validación robustos (coste adicional inicial).

- Seguridad y privacidad: El uso de LLMs (especialmente públicos) introduce riesgos de exposición de datos sensibles que deben gestionarse con herramientas y políticas adecuadas (posible coste de infraestructura/licencias).

- Dependencia tecnológica: Confiar excesivamente en una herramienta o proveedor específico de IA.

- Medición del valor: Dificultad inicial para cuantificar objetivamente el impacto de la IA en la eficiencia y la calidad.

- Resistencia al cambio:

- Equipo de Testing: Miedo a la pérdida de empleo o devaluación de habilidades tradicionales. Escepticismo sobre la fiabilidad de la IA. Resistencia a aprender nuevas habilidades técnicas.

- Equipo de desarrollo/otros: Posible desconfianza en la calidad de los artefactos generados por IA. Percepción de la IA como una «caja negra».

- Gestión intermedia/stakeholders: Preocupación por los costos iniciales vs. beneficios a largo plazo. Dudas sobre la madurez y estabilidad de las soluciones de IA.

- Presupuesto: La necesidad de inversión en formación, herramientas (potenciales licencias de LLMs, plataformas RAG/Custom GPTs) y tiempo para la experimentación puede generar fricción si no se justifica claramente el valor esperado.

Mitigación para el sponsor: Abordar estos puntos requiere un enfoque de gestión del cambio explícito: comunicación clara sobre los objetivos (aumento de capacidades, no reemplazo), inversión visible en formación, empezar con un piloto controlado para demostrar valor y aprender, establecer métricas claras desde el inicio, y gestionar las expectativas de forma realista. La clave es presentar la adopción de IA no como un coste, sino como una inversión estratégica en la eficiencia, calidad y competitividad futura del equipo de QA

Fuente inspiración: Future of Jobs Report 2025: 78 Million New Job Opportunities by 2030 but Urgent Upskilling Needed to Prepare Workforces